Искусственный интелект в руках злоумышленника

От переводчика

В конце февраля 2017 года состоялся воркшоп на тему “Угрозы от злоумышленников для искусственного интеллекта”. Присутствовал широкий спектр участников из государственных, частных, научных и общественных организаций со всего мира. Целью мероприятия было обсудить и проанализировать риски, привносимые недобросовестным использованием всё ускоряющегося в развитии искусственного интеллекта (ИИ). Обсуждения проходили при отсутствии прессы в соответствии с правилами Чатем-Хауса, а по результатам был подготовлен доклад, раскрывающий позицию участников. Данная статья является кратким и недословным переводом доклада.

Вступление

За последние годы сферы искусственного интеллекта (ИИ) и машинного обучения (МО) претерпели бурное развитие, открыв дорогу для проникновения этих технологий в различные сферы жизни. Для примера, ИИ является ключевым компонентом в системах автоматического распознавания речи, машинного перевода, спам-фильтрах и поисковых системах. Существующие прототипы представлены автономными автомобилями, электронными ассистентами для докторов, дронами для спасательных операций. В будущем существует надежда, что ИИ покроет потребности в выполнении неприглядных видов работ, ускорении научного прогресса, улучшении качества государственного управления. Мы находимся в предвкушении внедрения этих разработок, но также призываем обратить внимание и на возможности злонамеренного использования ИИ. Мы провели детальный анализ рисков, чтобы иметь возможность избежать или, по крайней мере, смягчить возможные негативные последствия, не замедляя при этом общее развития ИИ.

ИИ и МО изменяют ландшафт угроз безопасности для граждан, организаций и государств. Злонамеренное использование ИИ угрожает цифровой, физической и политической безопасности, определяя структуру и использование электронных систем будущего, что в перспективе потребует соответствующего регулирования. Данные отчет пытается ответить на следующий вопрос: как можно предвидеть, предотвратить и, если необходимо, смягчить последствия злонамеренного использования ИИ?

В рамках этого доклада мы концентрируемся на технологиях ИИ доступных или на сегодняшний день или кажутся реализуемыми в течении следующих пяти лет. Особый внимание мы уделяем технологиям МО. Мы рассматриваем только те сценарии, в которых ИИ используется для намеренного подрыва безопасности других лиц, организаций или коллективов, в отличии от других исследованиях, концентрирующихся на непреднамеренных эффектах. Также мы не рассматриваем непрямые последствия повсеместного внедрения ИИ, таких как массовая безработица.

Общая структура угроз, связанных с ИИ

Возможности ИИ

Целью ИИ является автоматизация как можно большего спектра задач. Типичные проблемы, находящиеся в фокусе исследователей в области ИИ включают в себя, среди прочего, игры (пошаговые и реального времени), управление автомобилями и дронами, классификацию изображений. Любая комплексная проблема, решаемая людьми и животными является потенциальной целью для автоматизации с помощью ИИ.

В то время как изучение ИИ уходит корнями в пятидесятые годы прошлого столетия, стремительный прогресс, достигнутый в последние годы кардинально увеличил значимость этой сферы. Экспоненциальный рост вычислительных мощностей, современные методы МО, появление необходимого программного обеспечения, увеличение доступности наборов данных для обучения позволило резко повысить качество решения типичных задач.

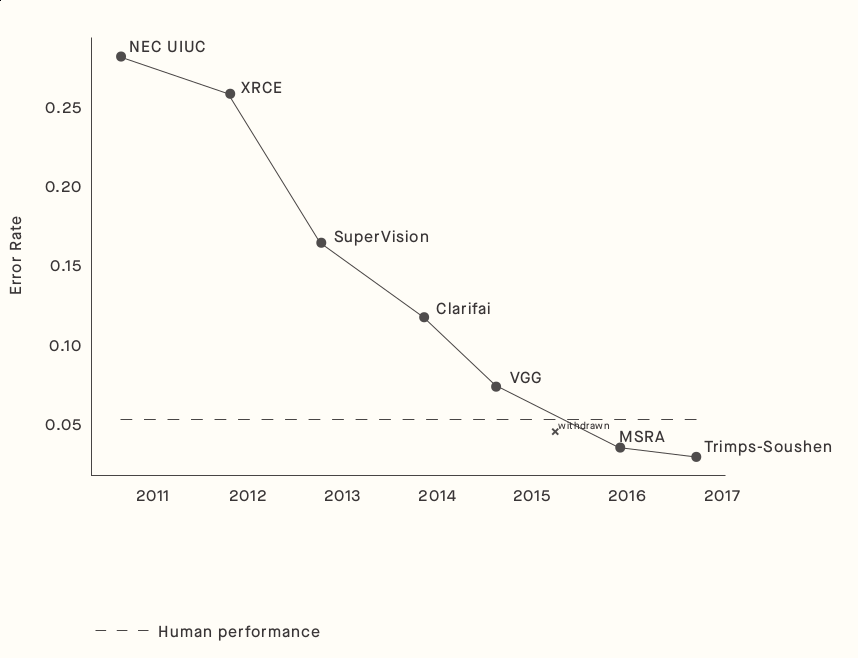

Приведенный график иллюстрирует динамику улучшения качества распознавания объектов, представленных на изображениях из широко используемого набора ImageNet. За последние несколько лет системы на основе МО превзошли человеческую точность в 95%. Иллюстрация ниже показывает еще более поразительный пример развития систем ИИ, способных генерировать изображения несуществующих людей, не отличимые от настоящих. Хотя, еще несколько лет назад подобные изображения лишь отдаленно напоминали реальных людей. Впечатляющий прогресс также был достигнут в качестве игры ИИ по сравнению с игроками-людьми в динамичные игры, такие как Atari, Dota 2, или пошаговые, такие как шахматы и Го.

С точки зрения безопасности, многие из недавних прорывов заслуживают пристального внимания. Например, способность распознавать лица и умение эффективно ориентироваться в пространстве открывает широкие возможности для автономных боевых систем. Или же, способность генерировать реалистичные изображение, тексты и аудио может быть использовано, чтобы эффективно изображать в интернете реальных людей и влиять на общественное мнение, распространяя синтезированный контент через социальные сети. Данные примеры основаны возможностях ИИ ожидаемых в обозримом будущем. Хотя предсказать прогресс в отдельно взятых задачах предсказать трудно, общий потенциал подобных систем может оказать гораздо шире.

Стоит отметить, что спектр задач, в которых ИИ показывает своё превосходство над человеком остается все еще очень узким. Но однажды достигнув уровня, близкого к человеческому, машинное обучение, как это случилось в шахматах, довольно быстро обходит в возможностях даже самых талантливых людей. Абсолютное большинство исследователей в области ИИ ожидают, что в конечном итого искусственный интеллект достигнет или даже превзойдет человеческий. Но вместе с тем, большинство не считают подобное вероятным в течении ближайших пятидесяти лет. Последствия подобного развития трудно предвидеть, поэтому анализ на столь отдаленную перспективу выходит за рамки данного отчета.

Свойства ИИ, относящиеся к безопасности

Мы ожидаем, что в скорости системы искусственного интеллекта начнут рассматривать, как технологии двойного предназначения. Не видится возможным создания технологий ИИ, которые принципиально невозможно будет использовать со злонамеренными целями. Примерами могут служить системы для нахождения уязвимостей в программном обеспечении или дроны, которые с одинаковым успехом могут доставлять как почту, так и взрывчатку.

Системы ИИ обычно являются эффективными и масштабируемыми. Эффективными в том смысле, что однажды обученная система может справляться с соответствующими задачами быстрее и дешевле человека. Масштабируемость означает, что, в отличии от людей, один и тот же экземпляр системы может быть запущен многократно без необходимого на это дообучения.

Системы ИИ позволяют увеличить анонимность и психологическую дистанцию. Отсутствие непосредственного контакта, с людьми, участвующими в некоем процессе, может существенно повлиять на само поведение участников. Важность психологической дистанции может быть проиллюстрирована примером того, что даже операторы военных дронов, наблюдающие за целью и нажимающие спусковой крючок часто становятся жертвами посттравматического стрессового расстройства. Увеличение анонимности, в свою очередь, может облегчить совершение действий, которые в противном случае могут вызвать резкую обратную реакцию в отношении инициатора действия.

На данный момент культура научного обмена является чрезвычайно открытой в сфере ИИ. Хотя подобная ситуация благотворно влияет на появление новых идеи, облегчается попадание потенциально опасных технологий в плохие руки.Pattern

Сами системы ИИ подвержены большому количеству ранее неизвестных атак, для которых не существует эффективных общепринятых мер противодействия. К таким атакам относятся “заражение” тренировочных данных, подготовка намеренно враждебных (adversarial) данных для рабочих систем, нахождения уязвимостей в целепостановке.

Возможные последствия

В отсутствии адекватных контрмер, прогресс в ИИ буде сопровождаться расширением существующих угроз, появлением новых угроз и изменением характера угроз. Атаки станут более эффективными, более направленными, их будет сложнее отследить и установить принадлежность атакующего.

Расширение существующих угроз будет проявляться в расширении числа лиц, способных провести атаку, облегчении каждой отдельной атаки и увеличении круга потенциальных жертв. Одним из примеров являются фишинговые атаки, которые благодаря ИИ будут требовать куда меньшей человеческой вовлеченности для подготовки психологического профиля жертвы и смогут вести куда более персонализированную переписку с жертвой. Может даже отпадет необходимость в том, чтобы злоумышленник и жертва говорили на одном языке. Увеличение доступности эффективных систем ИИ является не единственных фактором, влияющим на расширение существующих угроз безопасности. Другими факторами являются уменьшение стоимости и увеличения доступности оборудования, необходимого для конструирования роботов. Исламское государство уже продемонстрировало пример использования любительских дронов в воздушных атаках.

Принципиально новыми угрозами являются, ранее недоступные, появившиеся благодаря ИИ, возможности. Например уже сейчас существуют коммерчески доступные технологии синтеза голоса конкретных людей. Другим примером является “рой” дронов, в котором каждый дрон запрограммирован на убийство конкретного человека. Без ИИ управление подобным роем не представляется возможным. Широкое использование автономных автомобилей может быть подвержено угрозам появления враждебных изображений на открытых пространствах. Люди, не имея возможности самостоятельно обнаружить такие изображение, будут иметь трудности в предотвращении возможной трагедии. Более того, атака может осуществляться на большое количество автомобилей одновременно.

В наше время нападающим приходится находить баланс между масштабами и частотой атак. С использование систем ИИ многое задачи по организации атаки могут оказаться решаемыми гораздо меньшими ресурсами, существенно влияя не те компромиссы, на которые нападающему приходится идти сегодня.

Сценарии

Примеры в этом разделе имеют целью проиллюстрировать приложения ИИ, имеющие потенциал быть использованными злоумышленниками в области цифровой, физической и политической безопасности.

Для безопасности в цифровой сфере угрозой станет существенное упрощение автоматизация атак, основанных на социальной инженерии. Информация о жертве, доступная как в открытых так и закрытых источниках может быть использована для создания индивидуализированных фишинговых ссылок, имейлов, сайтов. В недалеком будущем, в организации подобных персонализированных атак могут использоваться чат-боты или даже видео-боты, имитирующие знакомых жертве людей.

Автоматизация поиска уязвимостей в программном обеспечении является другим направлением в сфере цифровой безопасности. ИИ также может быть использован на всех этапах реализации атаки, в том числе и заметания следов или даже сокрытия самого факта совершения атаки. Например, атаки типа отказа в обслуживании (Denial-of-Service, DoS) могут имитировать человеческое поведение, повышая сложность защиты, которая не будет отражаться на конечных пользователях. Также, технологии анализа больших данных могут упростить идентификацию наиболее уязвимых жертв. Сами же математические модели, используемые в ИИ могут быть подвержены атакам через “отравление” данных, создавая угрозу возникновения трудно обнаружимых бэкдоров в критических системах.

В области физической безопасности появляется террористам открывается возможность использования общедоступных коммерческих продуктов, таких как камеры наблюдения, роботы-уборщики или дроны. Появления систем самоприцеливания для снайперских комплексов значительно снизит входной барьер для использования подобного оружия. Сам масштаб может резко увеличиться, например если один человек запустит сразу несколько дронов на одновременный поиск нескольких целей. Упрощается создание комплексных атак с “часовым механизмом”, когда сама атака будет автономно разворачиваться уже в момент, когда атакующий не будет иметь непосредственного доступа к системе.

Сфера политической безопасности столкнется с невиданной доселе возможностью современных технологий для построения систем массового наблюдения; искусственному интеллекту тут будет отведена ключевая роль. Фабрикация фейковых новостей пополнится реалистичными видео и аудио материалами. Массовые компании по дезинформации, организованные при помощи социальных ботов могут вытеснить реальность из информационного поля большого количества людей.

Сферы безопасности

Классическими целями цифровой безопасности являются конфиденциальность, целостность и доступность цифровых систем. Для физической безопасности целями является защита людей и объектов инфраструктуры. Политическая безопасность строится на возможности вести искренний, свободный и продуктивный диалог среди участников политического процесса. В данном разделе будет описано текущее состояние вещей с точки зрения готовности к эффективному противодействию атак, усиленных ИИ; а также возможные меры, повышающие защищенность против новых типов атак.

Цифровая безопасность

ИИ уже используется в защитных целях в таких применения, как обнаружение аномалий (anomaly detection) и зловредного ПО (malware). В тоже время много современных систем прошли долгий период эволюции, увеличивая количество и сложность переплетенных между собой программных компонентов. Такая история плохо сказывается на пригодности таких систем к администрированию анализу с точки зрения безопасности. Одновременно с этим, в последние годы наблюдается повышенная активность со стороны государственных агентов в организации сложных и таргетированных атак, таких как Stuxnet и атака на украинскую электросеть в 2015 году. Организованные преступные группировки тоже часто не отстают в профессионализме.

Усилия со стороны “белых хакеров” по ответственной публикации уязвимостей часто исходят из академической среди и имеют довольно ограниченный масштаб. В то же время для злоумышленников существует сильная финансовая мотивация, в том числе и в готовности идти на дополнительные расходы, не доступные белым хакерам. Хотя на данный момент неизвестны успешные атаки с массированным использованием ИИ, появление таковых ожидается в ближайшем будущем большим количеством экспертов в области безопасности. В связи с этим государственные структуры проявляют неподдельный интерес к технологиям МО и ИИ, отводя им главную роль в будущей кибербезопасности.

Недавно исследователи из ZeroFox продемонстрировали возможность созданий полностью автоматической системы по синтезу персонализированных твитов на основе интересов пользователей, достигнув высокой вероятности клика по потенциально фишинговым ссылкам. И интерес в подобной технологии очевиден: российские хакеры “отправили десяти тысячам пользователям Twitter, работающим в Министерстве Обороны США, фишинговые сообщения явно высокого качества”. По всей видимости данная атака потребовала огромных человеческих ресурсов и ёё масштаб мог бы оказаться не в пример больше, будь в распоряжении российского правительства соответствующие технологии в области ИИ. Другим потенциальным примером может стать создание зловредного ПО, не обнаружимого обычными антивирусами. Для это в процессе создания прототипа вируса, он многократно тестируется на обнаружении множеством коммерчески доступных антивирусов и поддается автоматической модификации с целью сокрытия шаблонов, обнаруживаемых антивирусным ПО.

Полностью устранить все риски не представляется возможным, поэтому важно предпринимать комплексные меры на многих уровнях контроля информационными системами. Важной меры повышения защищенности против фишинговых атак является повышение осведомленности потенциальных жертв, как о принципиальной возможности таких атак, так и об их новых возможностях. Правительственное регулирование играет существенную роль. Среди проблем, которые еще только предстоит решить – эффективное межгосударственное взаимодействие в области киберпреступности. Правила ответственного раскрытия уязвимостей играют важную роль помогают увеличить надежность программного обеспечения.

Одним из современных трендов развития индустрии программного обеспечения является вся усиливающаяся централизация и связанное с этим уменьшение предельных издержек. По стечению обстоятельств централизация также имеет преимущества с точки зрения безопасности. Пожалуй самым удачным примером тут является фильтрация спама, обеспечиваемая Google. Большая концентрация данных позволяет выработать более эффективные механизмы защиты и одновременно с этом предоставляет полезный сервис огромному количеству пользователей. Другим примером являются создание централизованных черных списков IP-адресов, являющихся потенциальными источниками атак. Вместе с тем централизованные системы не лишены недостатков, основным из которых является тот факт, что компрометация единого компонента системы может привести к компрометации всей системы.

Многие атаки могут быть предотвращены, если негативные последствия атаки превосходят положительные. Негативные последствия для злоумышленника связаны непосредственно с возможностью надежной и доказательной идентификации источника атаки. Даже сейчас это необычайно сложная задача, особенно учитывая, что раскрытие методов идентификации часто является крайне нежелательным.

Все вышеуказанные аспекты не рассматривались с точки зрения использования возможностей современного ИИ. Важно чтобы эти возможности не изменили баланс в пользу злоумышленника.

Физическая безопасность

Многие из угроз физической безопасности исходят из современного использования электроники и компьютеров в боевых системах. Регуляторы и разработки, сфокусированные на защитах, не поспевают за прогрессом в развитии боевых роботов. Мы ожидаем, что стоимость технологий защиты будет все больше превышать стоимость соответствующих наступательных технологий. Причиной этого является тот факт, что атаки в физическом мире могут совершаться буквально в любой точки земного шара. Кроме того возможности малых групп по организации очагов дестабилизации за счет точечных ударов будут увеличиваться.

Мир переживает фазу экспоненциального роста количества роботов. Массовая роботизация ожидается во все новых и новых сферах общественной жизни: доставка дронами, автономные автомобили, боевые автономные роботы. Данное явление практически не знает географических рамок. Отдельные роботы при этом имеют тенденцию иметь все более и более широкое предназначение. Автономность является одним из наиболее ожидаемых характеристик.

Универсальность коммерчески доступных роботов создает большое количество возможностей для создания роботов в преступных целях, таких как дронов, начиненных взрывчаткой и имеющий своей целью, ликвидацию конкретных индивидов. Роботы, будучи постоянно подключенными к сети, являются уязвимыми к массированным атакам через неизвестные ранее уязвимости, давая злоумышленниками возможность захватить контроль над огромным количеством дронов одновременно. Подобная критика зачастую слышна в отношении интернета вещей (Internet of Things, IoT). Кроме того чрезмерная вера в автономных роботов открывает новые возможности по использованию социальной инженерии совместно с физико-кибернетически системами.

Несмотря на то что можно ожидать большей защищенности будущих роботизированных систем, высокая стоимость внедрения защит означает, что в течении определенного периода времени будет существовать окно для возможных успешных атак. Ожидается, что стандартизация и регулирования индустрии поможет ускорить переходный период. Регулирование системы дистрибуции потенциально опасных роботов может перенять некие аспекты рынков оружия и сильнодействующих медикаментов. Уже сегодня во многих странах существуют требования по регистрации пользователей дронов, сфера которых может быть расширена и дальше.

В ООН идут дискуссии по ограничению определенных видов боевых автономных систем, хотя вероятность появления подобного регулирования не видится высокой. Возможный вариант развития подобных дискуссий может вылиться в установления минимального уровня вовлеченности личного персонала в боевые действия, чтобы усилить негативные последствия от ведения боевых действий для государственного руководства. Хотя, эти правила не смогут остановить негосударственных организации от совершения атак.

В современных условиях физическую защиты реалистично организовать только для таких критических объектов инфраструктуры, как аэропортов, атомных станций, дамб. Возникает вопрос, будет ли этого достаточно, в случае, когда стоимость атаки благодаря внедрению ИИ упадет. Вселяет оптимизм в целом высокая эффективность борьбы государственных структур с неконтролируемым распространением взрывчатки.

Политическая безопасность

Искусственный интеллект меняет структуру коммуникации между людьми, компаниями и государствами, которые все шире используют автоматизированные системы для обменна данными. Информационные технологии оказывают влияние на политические институции через социальные сети. Масштабируемость цифровых технологий в определенных условиях может подрывать гражданский диалог посредством массовой фабрикации неправдивой, но все-же правдоподобной, информации.

Развитие технологий и политический процесс шли рука об руку в своем развитии. Нельзя не отметить роль семафорного телеграфа во время Наполеоновских войн, навигационной системы GPS во время Войны в Персидском заливе, социальных сетей во времена Арабской весны. При этом направление изменения баланса между участниками политического процесса при распространении новых технологий не всегда очевидно. Например, социальные медиа усиливают как протестующих, так и государственные органы: ускорение коммуникации для первых означает более легкий мониторинг для вторых. Некоторые эксперты отмечают тренд в направлении поляризации политических групп, вызванный, среди прочего, особенностями функционирования социальных сетей. Не последнюю роль тут играют алгоритмы, основанные на машинном обучении.

Современные информационные технологии привносят качественно новые возможности по обмену сообщениями. Р. Вальцман (другой Вальцман) считает: “Способность оказывать влияния фактически была ~демократизована~, поскольку любой индивидуум или группа может общаться и оказывать влияние сразу на большое количество людей онлайн”. Подобная демократизация не обязательно оказывает благоприятное влияние на демократию, исходя, например, из того насколько молниеносно лживые новости имеют способность распространяться.

Восприятие подобных явлений также определяется особенности политической культуры отдельных государств. В либеральных демократиях, новые принципы распространения информации воспринимаются, скорее, как нечто, к чему необходимо приспособиться. В то же время, авторитарный китайский режим явно пытается взять на вооружение современные технологии, чтобы усилить контроль над политическим дискурсом, ведущимся как онлайн, так и в личных беседах. Одной из самых ярких подобных мер является попытка со стороны китайского правительства по внедрению “рейтинга социального доверия” (social credit score) для своих граждан.

Долговременные последствия влияния ИИ на политическую жизнь до сих пор остаются неясными. Тем не менее, мы надеемся, что своевременное обсуждение возможных угроз даст возможность к ним подготовиться. Уже сейчас очевидно, что простота использования социальных сетей упрощает использование ИИ для контроля сети социальных ботов, притворяющихся реальными людьми с конкретными политическими взглядами. Уже сегодня подобные сети показали свою эффективность даже не смотря на то, что большая часть контроля над ботам осуществлялась со стороны реальных людей. Как уже ранее отмечалось, важную роль может сыграть использования ИИ в фишинговых кампаниях или фабрикации новостей (в том числе и видео). Особенно уязвимыми тут являются общества с низким уровнем доверия к государственным институциям или традиционным медиа.

Авторитарным режимам, имеющим возможность осуществлять массовую слежку за своими гражданами откроется возможность отслеживать противников с высокой точностью и детализацией. На данные же момент, полноценные и эффективный анализ данных для многих структур все ещё остается за гранью доступного. Естественно системы слежения могут быть объединены с роботизированными системами, имеющими возможность автономно осуществлять репрессивные меры. Цензура же может совершаться посредством предвзятого ранжирования политически окрашенной информации.

Существующие меры, находящиеся в разработки или уже действующие, не предлагают окончательного решения вышеобозначенных проблем. Особенно трудным видится ограничение использования ИИ со стороны авторитарных правительств.

Известны попытки по созданию технических мер по распознанию фейков и социальных ботов, а также методов по созданию медиа материалов, аутентичность которых возможно доказать. Хотя к убедительным решениям известные попытки на данный момент не привели. Осведомленность людей в важности использования зашифрованных каналов обмена сообщениями, возросшая после данных, опубликованных Э. Сноуденом, оказалась крайне важной для сохранения данных о личной жизни. Вместе с этим выросли как спрос так и предложения программного обеспечения, помогающего контролировать утечки личных данных.

Медиа платформы, заслуживающие явно меньшего доверия, существовали всегда, так же как и спам рассылки или недобросовестные маркетинговые приемы. Тем не менее всё это время находились люди, которые становились жертвами таких недобросовестных практик. Мы знаем, что спам стал гораздо меньшей проблемой благодаря усиливающейся централизации почтовых сервисов, возможно подобные же принципы могут быть перенесены и на сферу медиа.

Меры и рекомендации

В данном разделе предложены общие рекомендации для исследователей в области ИИ и МО, общественности, политиков. Также мы предлагаем приоритетные области исследования ИИ, имеющие особую важность для уменьшения рисков от злонамеренного использования ИИ. Меры, рекомендуемые в данном отчете, относятся как техническим, так и к нетехническим. Оба типа мер уже сейчас встречают противодействие как со стороны слабо технически осведомленных политиков, так и со стороны технических специалистов, не желающий задумываться о негативных для общества последствиях.

Первая рекомендация. Политики должны тесно взаимодействовать техническими специалистами в целях изучения, предотвращения и уменьшения потенциального вреда от злонамеренного использования ИИ. Здесь подразумевается и ответственность политиков не вмешиваться в развитие технического прогресса сверх необходимого.

Вторая рекомендация. Исследователи и разработчики ИИ должны серьезно воспринимать характер двойного назначения своих технологий, отдавая должное внимание мерам, ограничивающим возможности по злонамеренному применения своих разработок. Специалисты не должны активно участвовать в разработке правил, связанных с регулированием функционирования ИИ. Участие в исследовательских проектах должно рассматриваться так же и с этической точки зрения.

Третья рекомендация. Необходимо брать на вооружение лучшие примеры взаимодействия с технологиями двойного назначения из других областей.

Четвертая рекомендация. Необходимо расширять спектр участников дискуссии, связанной с угрозами ИИ. Представители из сферы бизнеса, гражданского общества, национальной безопасности, различных областей науки, не связанных с ИИ непосредственно – все должны быть вовлечены в ответственное отношение к ИИ.

Двоякая природа ИИ означает, что многие злонамеренные способы применения ИИ имеют вполне легитимное предназначение. Зачастую разница между легитимным и нелегитимным лежит в установлении адекватных предохранителей против злонамеренного использования. Так, к примеру, системы наблюдения могут использоваться как для поимки террористов, так и для подавления свободы обычных граждан. Информационные фильтры могут бороться с фейками, а могут бороться со правом на свободу слова. Одна и та же технология может принести как много зла, так и пользы. Именно поэтому так важен как можно более широкий публичный диалог.

Данный отчет также предлагает несколько приоритетных областей для изучения экспертами по безопасности в области ИИ.

Обмен опытом с экспертами в цифровой безопасности. Как уже ранее упоминалось, с ростом возможностей систем ИИ, соответственно растет и эффект от атак на подобные системы. Примерами, интересных с точки зрения систем с ИИ, приемов из области цифровой безопасности являются:

-

Ролевые игры. Особый способ выявления уязвимостей системы, а также потенциального ущерба от успешных атак, путем организации группы экспертов, имеющих своей целью как можно более глубокое проникновение в систему. Системе при этом ущерб не наносится, а только проводится её анализ.

-

Формальная верификация. Целью формальной верификации является строгое доказательство соответствия реализации системы её спецификации. Даже для традиционного ПО подобная задача чрезвычайно сложна. Возможно ли верифицировать систему использующую ИИ? Существуют ли альтернативное подходы, дающие похожие гарантии?

-

Ответственное раскрытие уязвимостей. Нужны ли процедуры, специфичные для систем с ИИ, для раскрытия уязвимостей? Или существующие на данный момент практики являются достаточными?

-

Предсказание важных с точки зрения безопасности возможностей. Помогут ли “белые” хакеры предсказать степень развития возможностей ИИ и использовать эти предсказания для улучшения качества защиты?

-

Программные инструменты. Разработка каких программных инструментов обеспечит возможность тестирования систем ИИ на наличие уязвимостей?

-

Защищенное аппаратное обеспечение. Могут ли меры по обеспечению безопасности быть встроены непосредственно в аппаратное обеспечения, например, предотвращая несанкционированное копирование, ограничивая доступ, содействуя проведению проверок и т. д.?

Изменение культуры открытости. Сегодня в среде исследователей ИИ чрезвычайная открытость скорее является нормой. Большая часть новых исследований становится доступной в формате препубликаций, до появления на конференции или в соответствующем журнале. Такое состояние вещей благотворно влияет на ускорение процесса обмена идеями и в целом на развитие области.

В то же время, подобная открытость открывает простор для недобросовестного использования новейших разработок. В связи с этим возникает важный вопрос: будет ли уместным ограничить скорость, с которой новые идеи, составляющие потенциальную угрозу безопасности, становятся публичными? В области компьютерной безопасности практики, задерживающие публикацию информации об уязвимостях, являются скорее нормой. Подобные задержки дают ответственным лицам время для того, чтобы закрыть уязвимость.

Хотя мы и предлагаем уменьшить открытость сообщества, мы осознаем пользу от беспрепятственного обмена идеями и наработками. Поэтому практики по ограничению открытости должны принимать во внимание те возможности, которых сообщество лишается по причине ограничений. К возможным мерам можно отнести следующие:

-

Оценка потенциальных рисков перед публикацией материала. Нужно ли проводить допубликационную оценку рисков с возможным ограничением степени открытости в описании результатов исследования? Подобные меры уже исзвестны в облаястях биотехнологии и цифровой безопасности. Возможно для ИИ подобные меры все еще преждевременны, тем не менее стоит выработать понимание того, когда же все-таки такие меры станут уместными.

-

Централизованный доступ сервисам ИИ. Контроль за использованием ИИ легче проводить в случае, если доступ к конкретным функциям осуществляется через централизованный сервис, куда пользователь отправляет входные данные, например, изображение, а получает ответ в форме конечного результата, например, в виде распознанных эмоций. Во-первых, это позволяет ограничить нецелевое применение систем ИИ. Во-вторых, подобная форма доступа позволяет контролировать степень использования сервиса. Тут изучению подлежит вопрос того, насколько всё же надежно данная мера ограничивает злонамеренные действия, а также несколько технически целесообразной останется централизация в свете дальнейшего увеличения компьютерных мощностей.

-

Нормы открытости, благоприятные для защиты и безопасности. Возможно ли установить такие нормы передачи результатов исследований в открытый доступ, при которых изначально доступ к соответствующим публикациям получает только ограниченный круг специалистов? Исследования, которые доступ к которым, мог бы быть таким образом ограничен могли бы относиться к системам ИИ, имеющим непосредственный потенциал для использования в атаках на информационные системы.

Поощрение культуры ответственности. Одни лишь ограничения не могут быть эффективны без развития культуры ответственного отношения к распространению потенциально опасных технологий. На сегодняшний день организации, занимающиеся изучением и разработкой ИИ, находятся в уникальном положении, позволяющем формировать критерии безопасности будущих систем ИИ. Представители научно-технического сообщества уже сейчас очень серьезно подходят к ответственности в создании безопасных систем ИИ. В дальнейшем важно вырабатывание всеобщее понимание тех рамок, в которых должны функционировать интеллектуальные системы. Риски от злонамеренного применения ИИ должны учитываться как в процессе обучения, так и найма, научных исследований и прикладных разработок, как отдельными лицами, так и организациями в целом. К отдельным областям, представляющим интерес для дальнейших исследований относятся:

-

Обучение. Какие формальные и неформальные методы обучения учёных и инженеров этическим и социальным нормам являются наиболее эффективными? Как лучше всего интегрировать данное обучение в программу обучения исследователей ИИ?

-

Этические нормы и стандарты. Какова в целом роль этических норм и стандартов в изучении ИИ? Кто их должен устанавливать и проводить в жизнь? Какие этические нормы, специфичные для цифровой, физической и политической безопасности, нужны для адекватной дифференциации между добросовестным и злонамеренным использованием?

-

Поощрение информаторов. Каким образом информаторы защищены в других областях и насколько информаторы полезны для предотвращения вышеозначенных рисков?

-

Реалистичные угрозы. Понимание того, какие угрозы являются реалистичными крайне важно для продуктивной дискуссии об искусственном интеллекте. Очевидно, что сценарии робоапокалипсиса и полной автоматизации таковыми не являются. Может ли сценарий “двойного назначения” рассматриваться, как более реалистичный?

Разработка технических и регуляторных мер. В добавок к новым вызовам и угрозам ИИ также открывает простор для создания новых видов защит. Технологические решения должны сопровождаться регуляторными мерами. В этой сфере представляется интересным для изучения вопрос того, какие институциональные меры могут минимизировать негативные последствия злоупотребления технологиями ИИ. К конкретным темам для дальнейшего изучения относятся:

-

Защита приватности. Какая роль в защите приватности отводится технологическим мерам, а какая институциональным?

-

Координированное использование ИИ для общественной безопасности. Поможет ли широкое распространение защитных мер, использующих ИИ, эффективно противодействовать атакам, использующих ИИ? Кто должен быть ответственен за распространение данных технологий?

-

Мониторинг ресурсов, используемых ИИ. При каких условиях возможен и уместен контроль распространения аппаратного обеспечения, программ, данных и таланта, важных для технологий ИИ? Какие конкретно ресурсы должны мониториться?

-

Другие законодательные и регуляторные меры. Какие еще меры могут оказаться полезными в этой области?

Необходимо создание мотивации для исследования вышеупомянутых тем со стороны отдельных специалистов и организаций. Цель данного отчета – информирование общественности о существующих проблемах и их важности, а также очертить пути их решения.

Стратегический анализ

В долгосрочной перспективе уверенно предсказать каков будет результат от реализации мер, очерченных данным отчетом, невозможно. Тем не менее мы хотим очертить основные соображения для формирования более определенного представления о среднесрочной перспективе. Под среднесрочной перспективой подразумевается период от пяти лет и больше, в конце которого ИИ широко используется злоумышленниками, но до того как ИИ в состоянии действовать полностью автономно без контроля и управления со стороны человека.

Даже кажущееся равновесие между защитными и наступательными системами ИИ, исходящее из обозримых темпов развития ИИ в среднесрочной перспективе может оказаться недолгим, если темп прогресса неожиданно увеличится. Тем не менее мы надеемся, что данный отчет всё же корректно очертит перспективы ближайших лет.

Факторы, определяющие равновесие в области безопасности

На данный момент в исследовательских кругах сложилась культура наискорейшего обмена к новейшим достижениям. Это существенно облегчает для злоумышленников задачу создания зловредных систем ИИ благодаря беспрепятственному доступу к новейшим технологиям. Мы ожидаем, что данная угроза в скором времени станет очевидной как для разработчиков новых технологий, так и для регулирующих органов. В тоже время остается открытым вопрос об эффективности любых ограничений в этой сфере. Мы ожидаем от международных организаций обеспечения превентивного внедрения необходимых организационно-технических мероприятий, в противном случае необходимые меры придется принимать в виде ответа на последствия серьезной атаки или скандала. Не стоит ожидать полной надежности от любых ограничительных мер при защите от могущественного нападающего, но хотя бы против менее могущественных атакующих меры по ограничению распространения новых технологий в области ИИ могут оказаться эффективными.

Те же факторы, усиливающие возможности злоумышленников идут на пользу и разработчикам механизмов защиты. Интересными областями для внедрения ИИ могут стать криминальные расследования или борьба с терроризмом. ИИ уже широко используется правоохранительными органами для целого ряда задач, таких как распознавание лиц или анализ социальных сетей. Мы ожидаем в скором времени, что сюда можно будет добавить раннее обнаружение атак и автоматическая реакция на них, а также много других технологий. В то же время данные технологии несут в себе опасность по усилению авторитарных режимов.

Мы ожидаем, что объекты критической гражданской или военной инфраструктуры будут в состоянии обеспечить себя наилучшими из доступных инструментами для защиты от нежелательного проникновения. Особенно, учитывая, что определенные защитные механизму могут быть разработаны небольшими лабораториями или стартапами. В то же время ситуация может сильно ухудшиться для большинства потенциальных жертв: технологически отсталых организаций или страдающих недофинансирования государств и компаний. Для обеспечения безопасности таких потенциальных жертв важно сделать механизмы защиты общедоступными путем, например, регуляторных мер или обеспечения низкой стоимости владения. Последнее может исходить от технологических гигантов (как в случае со фильтрами спама) или некоммерческих организаций (как в случае браузера Mozilla Firefox). С точки зрения политической безопасности общедоступные решения для подтверждения подлинности фото, аудио и видео материалов также являются предпочтительными.

Провал в стимулирующих мерах может повлечь за собой провал в обеспечении безопасности в целом. Так повышение защищенности IoT устройств уменьшает эффективность потенциальной атаки. Но пользователи таких устройств, являющиеся главными заинтересованными в повышении собственной безопасности лицами, в целом не в состоянии повысить защищенность используемых ими устройств. Поэтому в таких случаях государственное регулирование являет собой необходимую меру для стимулирования разработчиков в защите данных своих клиентов.

Общая оценка

Мы ожидаем, что злоумышленники будут использовать ИИ, наряду с обществом в целом, все более и более интенсивно, аналогично тому, как террористы и авторитарные режимы, наряду с обществом в целом, использую электричество, программное обеспечение и компьютерные сети. С другой стороны, есть и оптимистичные тенденции для защитных технологий. Все еще остается большое количество потенциальных открытий, не требующих больших вложений на разработку. Научное сообщество выглядит чрезвычайно мотивированным на поиск решений, повышающих безопасность систем ИИ. Кроме того, по крайней мере в некоторых странах, наблюдается серьезная заинтересованность в эффективном регулировании технологий ИИ.

С другой стороны не для всех известных потенциальных проблем предложено хотя бы концептуальное решение. Скорее всего защитить очень трудно будет защитить людей от манипулирования со стороны систем ИИ. В случае невозможности надежной идентификации злоумышленника осуществление наказание будет практически невозможным, что может создать состояние, когда жертва будет подвергаться атакам практически непрерывно. Такая ситуация угрожает подрывом общественного доверия и доверительным отношения между различными государствами.

IT и медиа гиганты могут продолжить оставаться техническими убежищами для массового пользователя, поскольку благодаря доступу к огромным массивам данных и владению каналами коммуникаций, они оказываются в необычайно привилегированном положении с точки зрения обеспечения защиты и безопасности своих клиентов. Большие компании из других отраслей (автомобилестроение, медицина, оборонные технологии и т. д.) скорее всего вынуждены будут следовать примеру поведения лидеров в IT и медиа. Подобные перспективы скорее всего лишь усилят тенденцию того, что люди все больше взаимодействуют с сервисами, управляемыми большими IT и медиа компаниями, и все меньше с сервисами, предлагаемыми небольшими компаниями и правительствами.

Национальные правительства будут вынуждены защищать своих граждан и политическую стабильность в целом от злонамеренного применения ИИ. Это может происходить через непосредственный контроль над цифровой и коммуникационной инфраструктурой, координированное управление со стороны частных и государственных организаций, или посредством действенной законодательной регуляции, устанавливающей для компаний требования по открытости.

Для решения иных проблем, требующих более сложной координации или экспертизы, могут понадобиться новые структуры, в том числе и международные. Это уже не первый раз в истории человечества, когда мир оказывается перед необходимостью решения новых глобальных проблем. Конференция НАТО в Гармише в 1968 породила консенсус вокруг растущих рисков, связанных с программным обеспечением, и выработала технические и процедурные рамки для избежания рисков, связанных с захватом, перефинансированием, невозможностью обслуживания и программными ошибками в объектах критической инфраструктуры. Практики выработанные по итогам данной конференции являются широко используемыми и по сей день. Конференция NIH в Азиломаре в 1975 году очертила риски, связанных с прогрессом в исследовании рекомбинантных ДНК, содействовала мораторию на определенные виды экспериментов, инициировала исследования по созданию биоизолирующих технологий, а также предложила базис для законодательного регулирования подобных исследований.

Между авторами данного отчета все еще остается множество разногласий касательно развития ИИ. Многие из этих разногласий может разрешить только действительное развитие событий. Тем не менее данные разногласия не должны стать сдерживающим фактором в подготовке к обозримому изменению структуры рисков, связанных с искусственным интеллектом и автономными системами.

Заключение

В то время как остается много неопределенного в развитии ИИ, ясным остаются все возрастающая роль ИИ в системах безопасности будущего, рост возможностей злонамеренных действий и очевидность того, что многое только предстоит сделать.

Искусственный интеллект, цифровая, физическая и политическая безопасность тесно переплетены и эта связь скорее всего только усилится. Сегодня, даже с текущими возможностями, ИИ может быть использован в качестве вспомогательного инструмента для организации атак и защит цифровой инфраструктуры. Системы ИИ уже сейчас превосходят человеческий потенциал в ряде узких задач, таких как игра в шахматы, Jeopardy!, Dota 2 и Го, находят применение в системах автоматизированного трейдинга или управления автомобилями. Скорее всего спектр задач, в которых ИИ будет иметь преимущество над человеком в ближайшее время существенно расширится. Поэтому необычайно важно быть готовыми к атакам, полагающимся на технический прогресс в области ИИ.

Даже в сферах, традиционно воспринимаемых, как исключительно человеческие (например, социальное взаимодействие), мы увидим атаки, использующие приемы социальной инженерии, полагающиеся на все более сложный искусственный интеллект. Остается надежда на то, что ИИ интеллект окажется полезным также и для защиты от подобных атак, хотя никакой панацеи тут не предвидится. Необходимо больше усилий в определении рамок открытости распространения технологий ИИ, разработке методов формальной верификации надежности систем, гарантиях широкого распространения регулирования ИИ, даже в технически отсталых частях нашего мира.

Хотя конкретных рисков связанных со злонамеренным использованием ИИ существует огромное множество, понимание основных закономерностей поможет в разработке базовых средств защиты. Мы призываем читателя подумать над тем как он может быть полезен в распространении понимания рисков, связанных с ИИ и принять участие в диалоге по определению тех мер, которые помогут сделать развитие ИИ безопасным для всего человечества.

Acknowledgements

We are extremely grateful to the many researchers and practitioners who have provided useful comments on earlier versions of this document, and who engaged us in helpful conversations about related topics. Given the number of coauthors and related conversations, we will surely forget some people, but among others, we thank Ian Goodfellow, Ross Anderson, Nicholas Papernot, Martín Abadi, Tim Hwang, Laura Pomarius, Tanya Singh Kasewa, Smitha Milli, Itzik Kotler, Andrew Trask, Siddharth Garg, Martina Kunz, Jade Leung, Katherine Fletcher, Jan Leike, Toby Ord, Nick Bostrom, Owen Cotton-Barratt, Eric Drexler, Julius Weitzdorfer, Emma Bates, and Subbarao Kambhampati. Any remaining errors are the responsibility of the authors. This work was supported in part by a grant from the Future of Life Institute.